Agentische KI im Realitätscheck: Im Banking angekommen, in der Governance noch nicht

AI Agents // Agentische KI ist aus dem Pilotenstadium heraus und im operativen Einsatz angekommen. Rund sieben von zehn Finanzinstituten nutzen heute AI Agents, die nicht nur Empfehlungen aussprechen, sondern eigenständig handeln. Doch Kontroll- und Governance-Strukturen hinken hinterher – mit Risiken bei Nachvollziehbarkeit, Rechenschaftspflicht und Abhängigkeit von Drittanbietern. Der Nutzen ist enorm, die Risiken ebenso.

Agentische KI markiert den Übergang von der blossen Entscheidungsunterstützung zur mandatsbasierten Ausführung. Im Zahlungsverkehr ist diese Entwicklung bereits erkennbar: Mastercard führt gemeinsam mit Partnern wie Stripe, Google und Antom «Agent Pay» ein, damit authentifizierte Agenten auf ausdrückliche Kundenanweisung Käufe durchführen können. Mit «Intelligent Commerce» geht Visa denselben Weg – delegiertes Einkaufen mit Ausgabenkontrolle, bei dem der Verbraucher die finale Entscheidung trifft. «Agent Payments Protocol» (AP2) von Google wiederum zielt darauf ab, die Authentifizierung und Zahlungsabwicklung durch Agenten plattformübergreifend zu standardisieren. Wenn Software Überweisungen ausführt oder Aufträge erteilt, verschwindet die Verantwortung eines Unternehmens nicht – im Gegenteil, sie wird sogar noch grösser. Die entscheidende Frage lautet heute nicht mehr nur «Können wir das?», sondern «Können wir belegen, warum der Agent so gehandelt hat, auf welcher Datengrundlage, innerhalb welcher Grenzen – und wer hätte eingreifen können?»

Der grösste Mehrwert der Anwendungen zeigt sich in der Praxis. Im agentischen Handel können Transaktionen durch klare Mandate und eine vorgelagerte Risikobewertung Sekunden vor der Abwicklung proaktiv gestoppt werden. Im Beratungsumfeld gewinnen Banken Zeit: UBS hat KI-Assistenten so skaliert, dass sie Rechercheergebnisse und Kontext auf Abruf liefern, und stellt Kunden Videozusammenfassungen von Analystenberichten bereit, die klar als KIgeneriert gekennzeichnet sind – das heisst, die menschliche Überprüfung bleibt weiterhin fester Bestandteil. Auf der Kontrollseite erweitern Schweizer Institute ihre internen KI-Kapazitäten und verschärfen zugleich die Compliance-Vorgaben. Die ZKB etwa verfolgt in ihrer öffentlichen Berichterstattung einen strukturierten, programmatischen Governance-Ansatz. Auch im Retailbereich ist die Richtung klar: Die Übernahme von Hyperplane durch die Nubank macht deutlich, was viele etablierte Institute gerade neu lernen müssen – die Qualität eines Agenten hängt weniger vom Modell selbst sondern mehr von der Dateninfrastruktur ab, also von Erfassung, Merkmalen, Identität und Feedback-Schleifen.

Wettbewerbsvorteile entstehen zunehmend dort, wo Kunden Vertrauen spüren. Wenn Agenten innerhalb vereinbarter Grenzen Kundenvermögen umschichten, strittige Gebühren anfechten oder Forderungen und Verbindlichkeiten orchestrieren können, gilt die Loyalität dem Institut, das beauftragte Ergebnisse zuverlässig liefert und jeden Schritt transparent erklären kann. Kundenbindung entsteht heute weniger durch eine elegante Benutzeroberfläche, sondern mehr durch verlässlich ausgeübte Mandate, lückenlose Prüfpfade und schnelles menschliches Eingreifen, wenn etwas schiefläuft. Deshalb sollte das Kriterium der Nachvollziehbarkeit nicht nur als internes Kontrollinstrument, sondern auch als Merkmal zur Kundenbindung verstanden werden.

Regulatoren sagen klar: Bestehende Regeln gelten

Die Aufsichtsbehörden formulieren kein eigenes KI-Regelwerk für Banken. Sie gehen vielmehr davon aus, dass bestehende Anforderungen an KI-Systeme auch in diesem Bereich gelten. Die britische Finanzaufsichtsbehörde ist in ihrer Formulierung klar: Bestehende Vorgaben zu Verhalten, Outsourcing, operationeller Resilienz und Modellrisiken gelten ebenso für KI-Systeme. Auch die FINMA verweist auf dieselben Anforderungen: Führung eines KI-Inventars, Klassifizierung, Testen und Überwachung von Risiken, nachvollziehbares Dokumentieren von Entscheidungen und Beibehaltung menschlicher Eingriffsmöglichkeiten – insbesondere, wenn Plattformen von Drittanbietern involviert sind. Für Schweizer Institute, die international tätig sind, bedeutet das: Sie müssen ein einheitliches Kontrollsystem schaffen, das sowohl prinzipienbasierten Erwartungen als auch lokalen Besonderheiten gerecht wird – und dies mit überprüfbaren Nachweisen statt mit Schlagworten belegen. Ein solcher Nachweis beginnt mit einem Mandat, nicht mit der blossen Zustimmung. Eine vage Zustimmung wie z. B. «Hilf mir beim Kauf», reicht nicht aus, wenn ein Agent Geld ausgeben oder Vermögenswerte umschichten soll. Banken sollten klar definierte und widerrufbare Mandate einführen, die den Anwendungsbereich (was der Agent tun darf), die Grenzen (wie weit er gehen darf), den Authentifizierungskontext (Gerät, Identität, Risiko) und den Widerrufsprozess genau definieren. Das gesamte Ökosystem bewegt sich in diese Richtung – AP2 und Agent Pay setzen beide auf überprüfbare Anweisungen und robuste Prüfmechanismen bei der Übergabe an die Zahlungsinfrastruktur.

Entscheidungstelemetrie: Warum wurde diese Massnahme ergriffen?

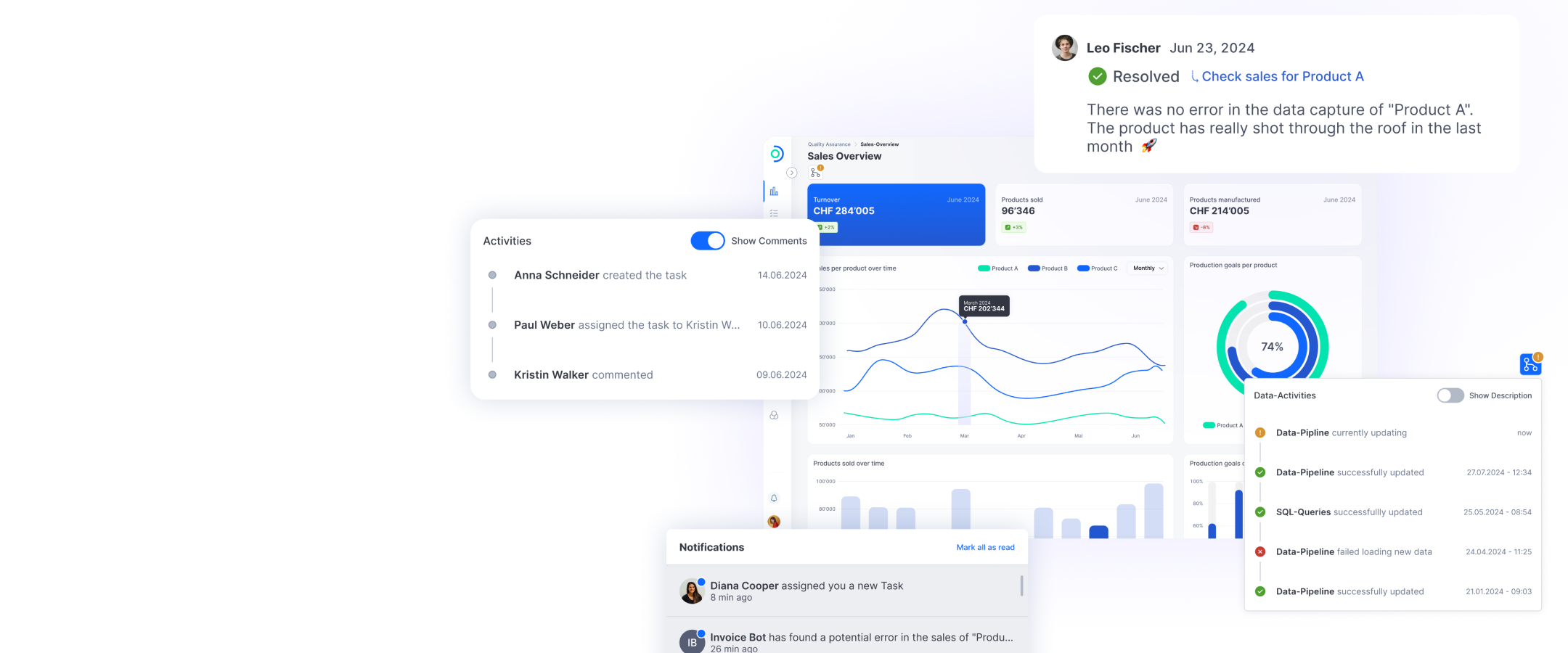

Als nächstes geht es um die Entscheidungstelemetrie. Agenten sollten als komplexe Systeme betrachtet werden, nicht als einzelne Modelle. Erfassen Sie Aufforderungen, Eingaben, Modell- und Richtlinienversionen, Regelverletzungen, Vertrauensschwellen, men-schliche Genehmigungen und Ergebnisse in unveränderlichen Speichern. Die Frage «Warum wurde diese Massnahme ergriffen?» sollte für Mitarbeitende, Auditoren und – bei Bedarf – auch für Kunden nachvollziehbar sein. Fehlt diese Nachvollziehbarkeit, werden Erklärungen nachträglich konstruiert und das Vertrauen schwindet genau dann, wenn Transparenz entscheidend ist.

Ein weiterer Kontrollpunkt sind die Schnittstellen. Die meisten Fehler entstehen an Übergabepunkten – etwa vom Agenten zum Zahlungsnetzwerk, zur Handelsplattform oder zum CRM-System. Richtlinien sollten deshalb genau an diesen Übergabepunkten greifen: Einrichtung standardmässiger Blockaden, wenn Grenzwerte, Zuständigkeitsbereiche oder Vertrauensschwellen verletzt werden; Verstärkung von Authentifizierungsvorgaben; Alarmierung von menschlichem Personal und Möglichmachen einer schnellen Rückabwicklung. Stufenweise Rollouts, ein Schattenmodus und klar definierte Abbruchkriterien sind notwendige Sicherheitsmechanismen, kein Theater. Darüber hinaus sollte man sich gezielt mit der Abhängigkeit von Drittanbietern auseinandersetzen. Die technische Architektur agentischer Systeme stützt sich auf Clouds, Modellanbieter, Vektordatenbanken, Orchestrierungsebenen und Zahlungspartner. Verträge sollten Audit- Rechte, SLA-Vorgaben, Datenstandort- Beschränkungen und Änderungshinweise bei Modellupdates enthalten. Wo Abhängigkeiten unvermeidbar sind, braucht es zumindest eine funktionsfähige interne Fallback- Lösung für kritische Prozesse.

Erste Schritte für Banken: Register, Mandate, Telemetrie

Was jetzt zu tun ist, ist klar. Richten Sie zuerst ein zentrales Register für AI Agents ein, in dem sämtliche Anwendungsfälle erfasst sind – einschliesslich Datenquellen, Schnittstellen, Risikoklassen und des jeweiligen Status menschlicher Kontrolle («Human in the Loop»). Entwickeln Sie einheitliche Mandatsvorlagen für Zahlungen, Aufträge und Kundenkommunikation. Diese müssen sowohl mit den technischen Regeln der jeweiligen Systeme als auch mit dem Schweizer Vertragsrecht übereinstimmen. Implementieren Sie vor der Skalierung eine Entscheidungstelemetrie und legen Sie eindeutige Sicherheitsgrenzen fest. Wählen Sie einen relevanten Prozess aus – zum Beispiel die Reklamation von Kreditkartenbuchungen, die Forderungsplanung oder die Aktualisierung von KYC-Daten –, führen Sie Red-Teaming-Szenarien durch (adversarielle Eingaben, Ausfälle von Dienstleistern, Marktturbulenzen) und entscheiden Sie anhand der ermittelten Ergebnisse, ob eine Skalierung erfolgen soll. Sorgen Sie für eine regelmässige Berichterstattung an den Vorstand, die über Restrisiken und die Wirksamkeit der implementierten Kontrollmechanismen informiert.

Fazit

Agentische KI ist bereits tief in Zahlungsprozesse, in die Bekämpfung von Finanzkriminalität und in den Kundenservice integriert. Die Gewinner dieser Entwicklung werden nicht jene Institute sein, die die meisten Agenten einsetzen, sondern diejenigen, die Handlungen klar an Mandate binden, Entscheidungen nachvollziehbar machen und menschliche Verantwortung sicherstellen. In der Schweiz ist die Richtung klar: Es gilt, die risikobasierten Erwartungen der FINMA umzusetzen, grenzüberschreitende Aktivitäten an prinzipienbasierte Rahmen wie den der britischen Finanzaufsichtsbehörde anzugleichen und Prüfbarkeit für Kunden sichtbar zu machen. Auf diese Weise wird autonomes Handeln zu einem vertrauenswürdigen Service.

ti&m Special «KI und Open Source»