«Bei Kreativitätsfragen überflügelt ChatGPT Menschen um Längen»

SwissGPT // Pascal Kaufmann vom Start-up AlpineAI ist sich sicher: Die Schweiz ist eine KI-Nation und bringt alles mit, um im internationalen Wettbewerb ganz vorne mit dabei zu sein. Mit SwissGPT will das Start-up Firmenkunden eine Schweizer Alternative zu ChatGPT und Google Bard bieten.

Mit AlpineAI trittst du an, der Übermacht aus den USA und China eine Schweizer Alternative entgegenzustellen. Warum spielt es aus deiner Sicht eine Rolle, wo die Technologie entwickelt wird?

Suchmaschinen wie Google oder eben auch Large Language Models wie GPT sind eigentlich Kulturmaschinen. Je nachdem, wer sie programmiert hat, werden ganz andere Lösungen präsentiert. Man spricht auch vom sogenannten Bias. Google zeigt unterschiedlichen Nutzern unterschiedliche Resultate an oder beantwortet gewisse politische Fragen ganz anders als eine chinesische Suchmaschine. Weil es eben auch um Werte und Kultur geht, ist es wichtig, dass diese Technologien auch aus Europa kommen. In der Schweiz sind wir politisch neutral, kulturell sind wir es aber nicht. Wir müssen diese Technologien verstehen. Und schlussendlich geht es auch um den Forschungs- und Innovationsstandort Schweiz.

Aber wie soll es ausgerechnet die Schweiz schaffen, eine ernst zu nehmende Konkurrenz für Firmen wie OpenAI zu sein?

Man muss nur einmal schauen, wer diese Large Language Models entwickelt hat, wer ganz zu Beginn dabei gewesen ist. Die Gründer von DeepMind waren Doktoranden aus Lugano, und das sehr bekannte Large Language Model Falcon hat seine Wurzeln in der Schweiz. Auch bei OpenAI haben Dutzende Expertinnen und Experten mit Hochschulbildung aus der Schweiz mitgearbeitet, die wegen Geheimhaltungsverträgen meistens nicht erwähnt wurden. Darum hat man das Gefühl, das war eine Silicon-Valley-Angelegenheit. Weltweit haben viele Labs dazu beigetragen, darunter zahlreiche europäische. Die Schweiz ist eine KI-Nation, das kann man quantitativ mit dem sogenannten Citation Impact Factor belegen: Schweizer Publikationen in den Bereichen Neuroscience, Robotik oder KI haben weltweit sehr hohe Citation-Werte. Es ist also kein Zufall, dass grosse Techkonzerne wie Alphabet (Google), Meta (Facebook), IBM, Disney und neuerdings Boston Dynamics in Zürich ihre Ableger haben. Sie profitieren von den Talenten und der Forschung an unseren Hochschulen und entwickeln daraus ihre Produkte. Man hat dann das Gefühl, das käme aus den USA oder aus China. Diese Position sollten wir wesentlich energischer ausnutzen und eben auch in der Schweiz Technologien entwickeln. Als Präsident des Swiss Artificial Intelligence Awards weiss ich, dass wir das Know-how dazu haben. Die Frage ist eher, ob wir das auch wollen.

«Wir sollten davon absehen, irgendein Regelwerk für KI-Ethik über die Welt stülpen zu wollen»– Pascal Kaufmann

Welche ethischen Aspekte hältst du im Umgang und bei der Adaption von KI für relevant?

Ethik ist ein schwieriges Thema, weltweit gibt es hier keinen gemeinsamen Nenner. Viele Studien zeigen, dass ethische Fragen je nach Kulturraum ganz anders beantwortet werden. Von einer KI-Ethik zu sprechen ist daher zu pauschal. Es gibt nicht einmal Menschenrechte, die weltweit akzeptiert sind. Solange viel fundamentalere Fragen des Zusammenlebens oder des Umweltschutzes nicht beantwortet sind, sollten wir davon absehen, irgendein Regelwerk für KI-Ethik über die Welt stülpen zu wollen. Ein Beispiel zum vorhin erwähnten Bias: Eine funktionierende Suchmaschine sollte so konzipiert werden, dass nicht nur alte weisse Männer gezeigt werden, wenn nach einem Beispiel für CEOs gefragt wird. Wenn man Biases eliminiert, verliert man allerdings auch viele interessante Aspekte, da ein Bias immer auch ein Menschenbild, eine Kultur repräsentiert. Menschen haben nun mal Vorurteile und Meinungen und das ist auch gut so. Entfernt man diese völlig aus den Large Language Models, hätte man ein ziemlich weltfremdes System. Ethisch finde ich übrigens, wenn wir in der Schweiz oder Europa das KI-Rennen gewinnen. Denn in einem diktatorischen Land baut man KI für eine autokratische Regierungsform, deren Werte weniger zu uns passen. Wir sollten daher nicht anstreben, Regulierungsweltmeister zu sein, sondern sollten ganz vorne die Richtung der KI-Entwicklung aktiv mitgestalten und Neues schaffen.

Was war eure Motivation, eine Schweizer Version von ChatGPT auf den Markt zu bringen?

Eine so wichtige Schlüsseltechnologie darf nicht einfach den USA oder China überlassen werden, beide Blöcke haben Aspekte, die wir aus der Schweiz ablehnen. Wir müssen das auch aus Europa, aus der Schweiz heraus verstehen. Am 15. Dezember 2022, also ein paar Wochen nach dem Release von ChatGPT, führten wir anlässlich des Swiss AI Dinner eine Sitzung mit 20 führenden europäischen KI-Forscherinnen und Forschern durch. Ich wollte natürlich wissen, was ihre Meinung zu ChatGPT ist. Denn wir waren uns damals nicht sicher, ob es sich dabei nur um einen neuen Hype handelt, obwohl wir alle erstaunt darüber waren, wie schnell die Nutzerzahl stieg. Rein technologisch sei ChatGPT eigentlich keine Revolution, so der Tenor damals, revolutionär seien eher die Nützlichkeit und das User Interface. An diesem 15. Dezember 2022 haben wir nach kurzer Diskussion entschieden, dass wir aus der Schweiz heraus SwissGPT aufbauen müssen. Nach der Firmengründung führten wir eine Pressenkonferenz Ende August 2023 am Flughafen Zürich durch, die grosse Beachtung fand. Seither haben sich über 600 Firmen bei uns gemeldet, die SwissGPT einführen möchten. Häufig verbieten es Gesetze, amerikanische Systeme zu nutzen, gerade im Kontext mit Daten der öffentlichen Verwaltung. Dies ist ein Markt für SwissGPT, der nicht so einfach durch OpenAI besetzt werden kann.

Welches sind eure wichtigsten Alleinstellungsmerkmale? Was ist an Falcon, dem SwissGPT zugrunde liegendem Sprachmodell, anders als bei der Konkurrenz?

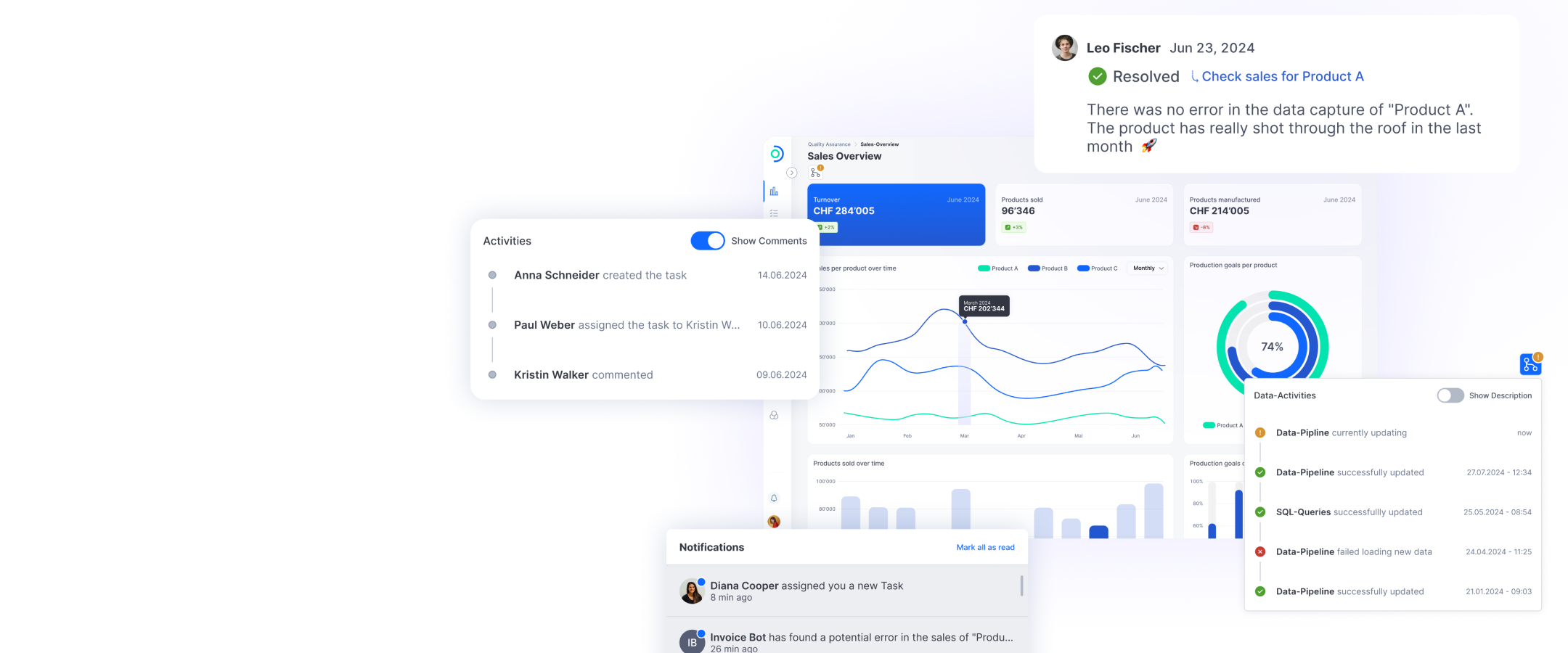

AlpineAI ist LLM-agnostisch und unabhängig. Das bedeutet, wir sind flexibel und können verschiedene Large Language Models einsetzen. Wenn morgen ein besseres Modell live geht und wir den Source Code nachvollziehen können, integrieren wir dieses Modell auch für SwissGPT. Damit wir Large Language Models nutzen können, müssen sie allerdings viele Kriterien erfüllen, beispielsweise die Richtlinien des EU AI Acts. Wir müssen exakt nachvollziehen können, wie sie trainiert wurden. Richtungsweisend ist hier die Stanford-Analyse von Juli 2023, die viele Large Language Models in der Welt verglichen hat. Insbesondere Falcon-2 schneidet heute sehr gut ab, weshalb wir uns auf dieses Modell konzentriert haben. Wir nutzen mittlerweile viele andere Modelle, allerdings schwingt Falcon oben aus und ist für viele Schweizer Bedürfnisse oftmals genügend. Aussergewöhnlich an AlpineAI ist die Zusammenarbeit mit vielen Schweizer KI-Laboren. Diese Art der Kollaboration ist in dieser Branche eher selten. Was uns auch von der Konkurrenz unterscheidet, ist unsere Vision, die über ein Large Language Model hinausgeht. Wir möchten einen Assistenten bauen, der es ermöglicht, dass wir nur noch sehr wenige Stunden pro Woche arbeiten müssen. Die anderen 40 oder 80 Stunden übernimmt der Assistent. Wir versprechen uns enorme Produktivitätsgewinne. Und in der Schweiz zusammen mit der hiesigen Spitzenforschung neuartige Algorithmen zu pilotieren, finde ich sehr interessant.

Was sind die nächsten Schritte in der Entwicklung von SwissGPT? Wird SwissGPT nur für Firmenkunden zugänglich sein?

Wir sind an Kooperationen mit Anbietern von grossen Workspaces dran mit dem Ziel, dass alle Mitglieder dieser Workspaces Zugang zu SwissGPT haben. Auch stellen wir SwissGPT wichtigen Institutionen wie Forschungslaboren oder Gemeinden und Kantonen zur Verfügung. Solche Initiativen gehen über die reine Nutzung von Firmen hinaus. Es ist nicht geplant, SwissGPT Individualpersonen anzubieten. Auch eine zuverlässige Infrastruktur ist wichtig, damit sich Firmen und Institutionen auf diese Technologie verlassen können. Unsere Server stehen bei uns in Zürich, vielleicht eines Tages auch in Davos. Da wir nicht auf ein einziges Large Language Model angewiesen sind, läuft unsere Lösung unterbruchsfrei, sollte eines ausfallen. Das macht SwissGPT zu einer sehr sicheren, zuverlässigen Alternative. Wir stellen unsere Lösung auch der Spitzenforschung zur Verfügung, wodurch wir uns interessante Entwicklungen versprechen, die wir wiederum für unsere Produkte-Roadmap nutzen können.

Für wie gut hältst du ChatGPT eigentlich? Was hat dich überrascht, wo sind die Schwachstellen?

ChatGPT hat mich enorm beeindruckt. Ich habe einige Fragen gestellt, bei denen ich – glaube ich zumindest – die Antwort kenne. Über Nietzsche, über die alten Griechen beispielsweise. Ich habe auch die Frage gestellt, wer gewinnen würde, wenn sich Hulk, der Terminator und ein Alien in einem Team und Superman, Iron Man und Batman in einem anderen Team gegenüberstehen. ChatGPT hat eine Analyse der Stärken und Fähigkeiten der Teams und Voraussagen gemacht, wie es ein Mensch nicht besser hätte machen können. Ich habe auch Kreativitätsfragen gestellt und die Antworten mit den Antworten von fünf Menschen verglichen, die die gleiche Fragestellung bearbeitet hatten: ChatGPT hat das Menschenteam um Längen überflügelt. Die wenigen Lösungen, die die Menschen in einer halben Stunde generierten, wurden durch die fast hundert Lösungen von ChatGPT in der Quantität, zum Teil auch in der Qualität, übertroffen. Das Zusammenfassen und Kombinieren von Texten sind verblüffend. Was nicht zuverlässig funktioniert, ist das Abrufen von Faktenwissen und Fragen, die mit Zahlen zu tun haben. Und Forschungsfragen mit unbekannten Antworten: Dann erfindet ChatGPT Antworten. Eine schlimme Schwachstelle, die man so einfach nicht beheben kann. Eine weitere Schwachstelle ist der enorme Energieverbrauch und die Ineffizienz der Algorithmen, das muss besser werden.

«Die Signifikanz von Large Language Models wie GPT ist fast nicht zu überschätzen. Für mich sind sie vergleichbar mit der Erfindung des Buchdrucks»– Pascal Kaufmann

Die Lancierung von ChatGPT ist mittlerweile über ein Jahr her. Was ist in diesen Monaten passiert? Ist der Hype immer noch da?

Ich sehe die aktuellen Entwicklungen als ein neues Kapitel in der Menschheitsgeschichte. Man kann die Signifikanz von diesen Large Language Models fast nicht überschätzen, sie sind für mich vergleichbar mit der Erfindung des Buchdrucks. Large Language Models beschleunigen die menschliche Kommunikation und bringt sie auf ein völlig anderes Niveau. In meinen Augen hat die Einführung von ChatGPT sehr vieles verändert. Von Large Language Models verspreche ich mir vor allem in der Spitzenforschung eine deutliche Beschleunigung. Sie können miteinander sprechen und komplexe Sachverhalte neu kombinieren.

Viele Firmen sind auf die aktuelle Entwicklung aufgesprungen und bieten mit Firmendaten gekoppelte AI Assistants an, die ChatGPT nutzen. Überrascht es sie, dass ChatGPT so schnell in Produktivität umgemünzt wurde?

So viele Businessmodelle oder Firmenlösungen, die Large Language Models produktiv einsetzen, gibt es noch nicht, da die Entwicklung noch jung ist. Man ist noch am Pröbeln. Viele juristische Fragen wurden noch nicht beantwortet, teilweise nutzt ChatGPT illegale Inhalte. Es laufen einige Gerichtsprozesse dazu. Firmen sollten sich gut überlegen, welche Technologie man einsetzt, weil man sich unter Umständen auch mitschuldig machen könnte. Insbesondere wenn es um kritisches Know-how geht, empfehle ich, vorsichtig mit Versprechen von US-Anbietern umzugehen. Man muss das Thema auch sprachlich differenziert betrachten: Viele technologische Neuerungen werden als künstliche Intelligenz bezeichnet, sind aber bestenfalls eindrückliche Automatisierungen. Wir müssen uns wohl noch ein paar Monate gedulden, bis wir wirklich interessante, messbare Business Cases sehen.

Was hat sich durch die Lancierung von ChatGPT in der KI-Welt getan? Merkt man einen neuen Drive in Entwicklungen, mehr Interesse von Studierenden?

Viele Forscherinnen und Forscher hat es erstaunt, wie einfach menschliche Sprache und Dialogfähigkeit durch relativ einfache statistische Gesetze und Regeln abbildbar sind. Man dachte, es brauche Intelligenz, so etwas wie ein Bewusstsein, um einen längeren Dialog führen zu können. Aber so wie es aussieht reicht reine Statistik. Diese Erkenntnis erstaunt und wird die KI-Forschung enorm beschleunigen. Dank ChatGPT hat die Online Community weltweit einen ersten Vorboten von KI erfahren können. Das Interesse ist enorm, viele junge Menschen wird es in dieses Gebiet ziehen und eine neue Generation von Forscherinnen und Forschern wird sich dem Gebiet annehmen.