Our Meeting Agent supports every phase of a meeting. Thanks to its intelligent features and cognitive capabilities, your employees are always perfectly prepared and receive reliable summaries and clear to-dos after every customer interaction.

Learn more

For many years we have been developing AI solutions based on ti&m’s expertise and our customers’ requirements. With our AI agents, assistants, and training courses, we offer tailored solutions that ensure effective and scalable applications for thousands of people.

Learn more

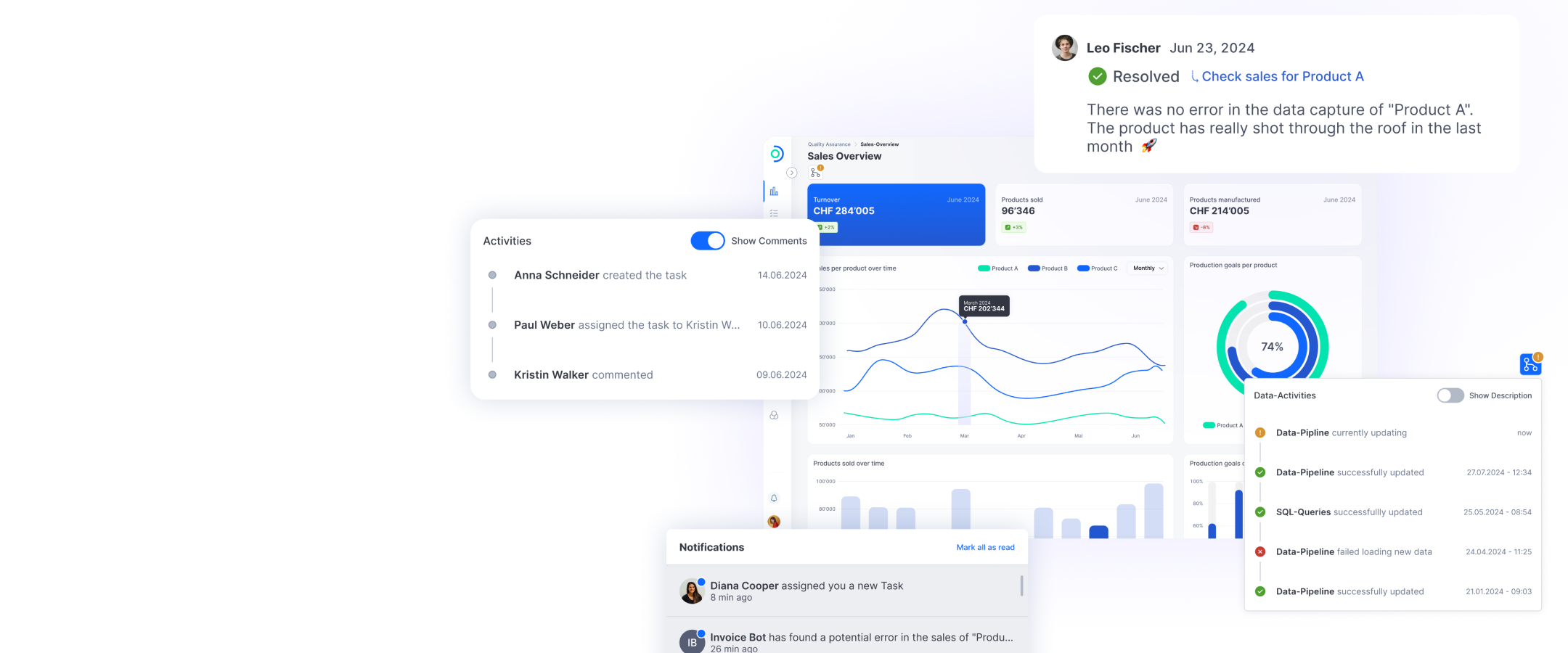

Open Datastack is a modular data platform that is based on open source components and is used both in the cloud and on-premises. The focus of Open Datastack is on interactive collaboration around data, dashboards and workflows.

Learn more

For many years we have been developing AI solutions based on ti&m’s expertise and our customers’ requirements. With our AI agents, assistants, and training courses, we offer tailored solutions that ensure effective and scalable applications for thousands of people.

Learn more

The Innovation Ranking 2025 ranks ti&m among the most innovative companies in Switzerland: ti&m is among the top 10 in the categories ‘Top 150 innovators in Switzerland’ and ‘Innovation culture’.

Discover our awards

In a comprehensive study, the Handelszeitung together with Statista identified the best employers in Switzerland in 2025. We are proud to have secured third place in the "Internet, Telecommunications and IT" sector.

Discover our awards

Why AI and open source belong together: How open source gives organizations long-term control over technology and data while also strengthening digital sovereignty and security in the use of AI.

Download nowOur industry expertise includes services in the AI, banking, insurance, public, transportation, e-government, retail and industry sectors.

ti&m Banking is a modular financial technology platform to deliver fulfilling banking experiences in retail, corporate and private banking.

Our industry-specific solutions combine years of industry experience with technological expertise and can be tailored to meet your company's specific needs.

Central information on ti&m: Key data, sites, values, executive board, customers, partners, and much more.

Exciting roles on IT projects, extraordinary events and countless benefits all await you at ti&m. Apply now and surf with us!

An insight into ti&m – you'll find everything you need to know here about events, academy, ti&m specials, downloads and press releases.